-

应用冷冻电镜技术研究蛋白质机器的统计物理性质

应用冷冻电镜技术研究蛋白质机器的统计物理性质欧阳颀 中国科学院院士 浙江大学

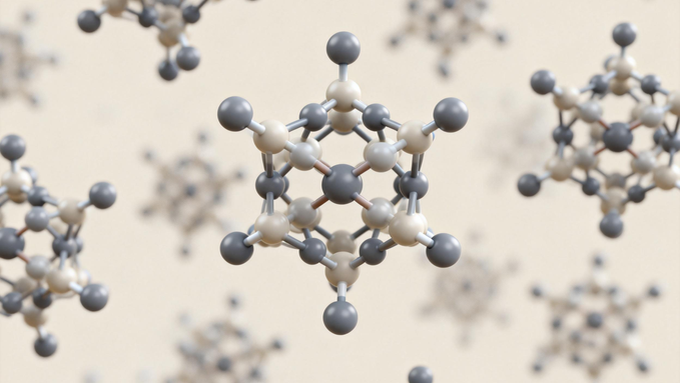

定量地理解生命过程并对生命系统做出精确的预测是本世纪交叉科学的核心任务之一。对生命过程越来越精确的检测手段给与完成这个任务强有力的技术支撑。这个报告将介绍冷冻电镜技术在研究蛋白质机器统计物理性质中的应用。报告以研究蓝藻菌的生物节律系统为例,探讨应用冷冻电镜技术研究蛋白质机器的非平衡统计物理与动力学性质的可能性。人工智能技术在此类研究中是研究路线的重要环节。 -

从动力学角度理解深度学习动力学

从动力学角度理解深度学习动力学赵鸿 教授 厦门大学

尽管深度学习取得了巨大的成功,但是其机理依然缺乏系统性理解,深度网络包括大模型依然被认为是“黑箱”。多年来,对机理的理解主要从整体分析的角度,试图利用数学工具或统计物理理论等刻画其整体性质。本报告强度学习模型一般都可以看成动力学系统,原则上应当借助非线性动力学理论进行刨析和理解。我们据此提出了一套动力学分析框架研究深度学习机理,这一框架包括以下主要内容:(1)基于神经元变换的保序或不保序特征,引入局域线性和非线性学习模式。这放弃了以神经元传输函数定义网络线性与非线性的通常做法,重新从本质上定义了学习模型的线性与非线性,定量刻画各层的非线性度。线性学习模式可以由单个神经元实现,而非线性学习模式需要多个神经元构成网络协同实现。由于定义在神经元和神经元组合层面上,因此我们可以分析神经网络每个局部的线性和非线性,从而能探测不同部分的学习动力学。(2)定义了输入矢量空间和权值矢量空间吸引域,分别刻画网络的推广能力和结构稳定性。吸引域是动力学系统的基本概念,而深度学习网络由于逐层迭代,从而具有吸引和吸引域的特征。两种吸引域具有不同的参数依赖,从而导致推广能力和结构稳定性的复杂依赖关系。基于这些概念,将揭示学习过程中学习动力学的突变及其所导致的“顿悟”与双下降等现象,揭示深度网络优越于浅层网络的动力学根源,揭示 regularization、batch size、learning rate、dropout 等常用策略起作用的机制。 特别是,我们将展示这套分析方法可以很好地展示 transformer 构架下各部分的学习动力学和结构与功能的演化,从而为分析和解剖大模型提供了一种工具。 -

多比特超导量子器件及其量子模拟和算法研究

多比特超导量子器件及其量子模拟和算法研究王浩华 教授 浙江大学

2025 年诺贝尔物理学奖授予了 1985 年“在电路中发现宏观量子隧穿效应和能量量子化”的研究,这为后来诞生的超导量子比特奠定了理论基础。极低温条件下,在约瑟夫森结和电容并联的宏观超导电路即量子比特中,以 GHz 频率高速振荡的超导电流所储存的电磁波能量量子化,能级跃迁可通过微波脉冲调制,这类似于受原子核束缚的电子轨道跃迁。由于超导量子比特基于微纳工艺具有易耦合、易集成的特点,利用微波调制技术可以达到极高的测控精度,并且比特的相干性能一直稳步提升,超导量子计算的实验研究近年来取得了长足进步。这里我将介绍浙江大学在超导量子计算领域的实验进展,包括我们所研发的几款超导量子芯片,并阐明我们研发这些芯片的原则:综合考量比特数、相干性以及量子门操作/读出速度和保真度等关键指标,以追求芯片性能均衡且稳定的提升。我们的超导芯片采用 flip-chip 工艺,频率可调的量子比特/耦合器布臵在与控制/读出线路分离的基片上,以保证比特的高相干性。芯片采用的长程耦合臂可连接远距离的两比特直接做门操作,实现高连通架构。基于此我们实现了权重为 6 的稳定子测量,实验编码逻辑比特并展示了低开销的量子低密度奇偶校验(qLDPC)码。在百比特芯片上,我们基于数字化量子模拟手段在非无序量子体系中模拟了有限温下鲁棒的拓扑边缘态,验证了预热化机制能够抵御热激发扰动,为构建抗噪声的量子存储与操控技术提供了新思路。最后,我们尝试将百比特芯片用于组合优化问题的求解,实验测试了一种基于量子采样策略求解伊辛模型基态的量子-经典混合算法:该算法基于浅层电路实现量子采样,求解效率在数百至千比特规模有希望超越经典模拟退火算法。 -

自由能极小:从大自然到大语言模型

自由能极小:从大自然到大语言模型王磊 研究员 中国科学院物理研究所

本报告将从自能能极小这一基本原理出发,介绍生成式人工智能应用于物质科学研究的新进展。通过若干实例,我将讨论一系列迷人的跨学科联系:语言模型与化学直觉,强化学习与变分优化,流模型与准粒子。 -

机器学习驱动的物质模拟方法发展及其应用

机器学习驱动的物质模拟方法发展及其应用孙建 教授 南京大学

以密度泛函理论(DFT)为代表的第一性原理计算方法,在物质科学的多个领域被广泛使用,推动了计算模拟的迅速发展。然而,由于第一性原理计算本身的计算成本高,此类方法通常受限于较小的空间与时间尺度,难以满足对复杂材料体系进行大规模、长时间模拟的需求。与此同时,数据驱动的材料研究正蓬勃发展。2024 年诺贝尔物理学奖与化学奖的相继颁布更象征着 AI 时代 的正式到来,也为第一性原理计算及物质模拟带来了前所未有的历史性机遇。在本报告中,我将简要介绍我们课题组自主开发或参与开发的多个机器学习驱动的物质模拟方法,包括基于机器学习与图论的晶体结构搜索方法 MAGUS,高精度消息传递型机器学习力场 HotPP,以及机器学习加速的分子动力学引擎 GPUMD 等。这些方法以神经网络势能面替代复杂的密度泛函理论计算,在保持接近第一性原理精度的同时,将计算效率提升了多个数量级,从而突破了传统量子力学计算在时间和空间尺度上的限制,使得开展大规模、高保真度的物质模拟成为可能。基于以上方法,我还将介绍它们在多个研究方向中的典型应用,包括行星内部物质的性质预测、新材料的预言,以及材料相变路径的动力学模拟等。更进一步的,我也将介绍我们最近发展的机器学习哈密顿量方法,以及一些潜在的应用。

第205次:数理科学与人工智能

论坛执行主席

-

龚新高院士

龚新高院士

-

段文晖院士

段文晖院士

-

王小云院士

王小云院士

-

谢心澄院士

谢心澄院士

-

-

论坛日期:2025年12月12-14日

论坛地点:南京南大国际会议中心一楼紫金厅

承办单位:中国科学院数学物理学部、中国科学院学部学术与出版工作委员会

主题报告

主办单位:中国科学院学部学术与出版工作委员会

技术支持:中国科学院计算机网络信息中心

关于学术引领网站上的任何文字、图片、视频资料的使用必须经过中国科学院学部工作局的许可

© 1996 - 中国科学院 版权所有 京ICP备05002857号-1 京公网安备110402500047号

通讯地址:北京市海淀区中关村北一条15号(100190)